MCP协议被捐给了一个基金会,Anthropic是发起方

解读:

function call 与 MCP 的根本区别(以及为什么 MCP 会诞生)

1 | 一句“总括本质”的话: |

MCP 的出现(2024年 11月 25日) ,25年3月被广泛使用,并不会让function call消失。

1 | MCP 是“在 function call 之上补全整个生态的协议层”,二者是协同关系,而不是替代关系。 |

正文

在刚刚结束的“美国 AI 春晚” AWS re:Invent 2025 大会上,AI Agent(智能代理)的重要性被反复提及。

亚马逊云科技 CEO Matt Garman 宣布的 12 项有关 AI 的新发布,都围绕着 Agent 的基建、开发和管理。在演讲中,他下了一个判断:AI Agent 的出现,正在让 AI 的价值真正释放。

“让 Agent 自主处理复杂任务”——这个未来看似美好,可实现起来困难重重。因为在现实的代码世界里,开发者面临着碎片化的难题。每个大模型都有自己的工具调用格式,每个数据源都需要单独编写连接器,且随时可能因为厂商的 API 变动而失效。

不过,这一困局似乎迎来了它的转折点。

12 月 9 日,Linux 基金会牵头 OpenAI、Anthropic 等科技公司,正式宣布成立 Agentic AI Foundation(代理人工智能基金会,简称 AAIF)。

更令人意外的是,Anthropic 宣布将其重要工具—— Model Context Protocol(模型上下文协议,MCP)捐赠给该基金会。 一同被捐赠的还有OpenAI 的AGENTS.md 和 Block 的goose 框架。

开发者需要的不是更多模型,而是通用标准

要理解此次 Anthropic 捐赠的意义,须从开头提及的开发者面临的碎片化难题说起。

过去的一年里,AI 行业虽然在模型能力上突飞猛进,但在应用层的基础设施建设上却显得步履蹒跚。开发者在构建智能代理时,往往发现自己陷入了重复造轮子的困境。要让一个 AI 助手既能读取本地的 SQLite 数据库,又能操作 Slack 发送消息,还需要连接 Google Drive 读取文档,开发者必须针对所使用的模型(无论是 GPT-4、Claude 3.5 还是Llama)分别适配。

MCP 的出现原本就是为了解决这一痛点。一年前,Anthropic 在推出该协议时,将其定位为连接 AI 模型与数据源、工具之间的通用接口。

我们可以将 MCP 理解为计算机领域的 USB 接口:只要鼠标、键盘或打印机遵循 USB 标准,就可以插在任何品牌的电脑上使用。同样,只要数据源或工具支持 MCP 标准,任何支持该协议的 AI 模型(客户端)都能直接调用它们,而无需开发者编写复杂的中间层代码。

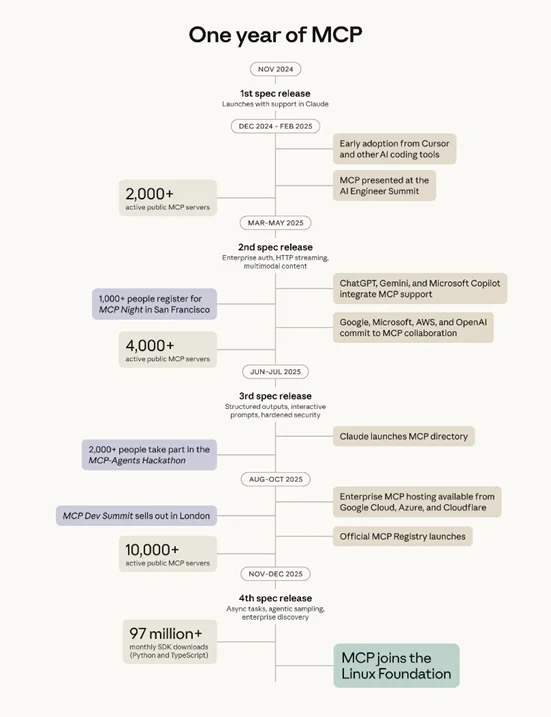

Anthropic 首席产品官迈克·克里格(Mike Krieger)在谈及此次捐赠时坦言,MCP 最初只是为了解决其内部团队面临的数据连接难题。但在 2024 年 11 月开源后,该协议迅速获得了社区的拥护,目前已有超过 10,000 个活跃的 MCP 服务器,涵盖了从企业级数据库到个人开发者工具的广泛场景。

此次将 MCP 移交至中立的 Linux 基金会,彻底消除了开发者的最大顾虑——供应商锁定。MCP 从此成为一个由社区共同治理的开放标准,任何厂商都无法单方面控制其发展,这为行业广泛采纳扫除了部分障碍。

Agent 铁三角:连接、规范与运行

仅有连接标准并不够,构建可靠的 Agent 还需要行为规范与执行框架。AAIF 的另外两个创始项目——OpenAI 的 AGENTS.md 和Block 的 goose——恰好补齐了 MCP 之外的拼图,共同构成了开发者构建代理应用的三大支柱。

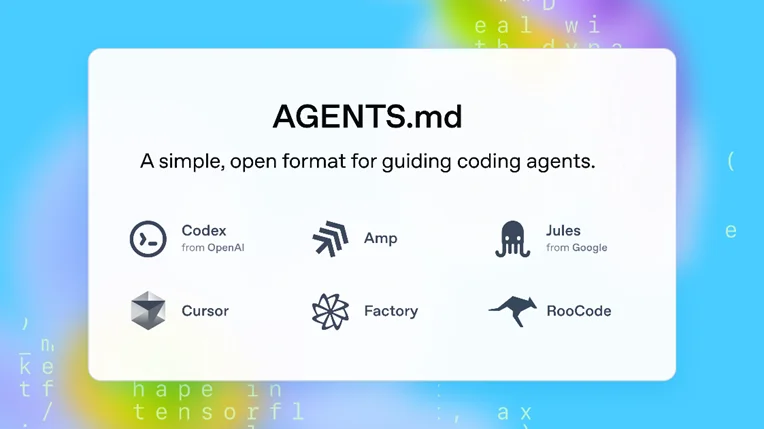

OpenAI 捐赠的 AGENTS.md 解决的是“上下文与行为规范”的问题。

在复杂的软件工程中,让 AI 代理接管代码库并非易事。AI 需要知道项目的架构、编码风格以及哪些文件是禁区。AGENTS.md 提供了一种极其轻量级的解决方案:开发者只需在项目根目录下放置一个标准化的 Markdown 文件,就能向任何访问该项目的 AI 代理“自报家门”。

这种方式避免了将大量上下文硬编码在提示词(Prompt)中,既节省了 Token 成本,又提高了代理执行任务的准确性。据 OpenAI 技术人员尼克·库珀(Nick Cooper)介绍,这种格式已被超过 60,000 个开源项目采用。

而 Block 捐赠的 goose 则是一个本地优先的代理框架。

它能够直接运行在开发者的机器上,利用 MCP 连接各种工具,并遵循 AGENTS.md 的指引来执行任务。Block 的 AI 技术负责人布拉德·阿克森(Brad Axen)指出,goose 并非实验品,而是已经在 Block 内部经过数千名工程师验证的生产级工具。对于那些不想从零开始构建代理运行时的开发者来说,goose 提供了一个现成的、开源的起点。

至此,技术框架已经十分明晰。开发者可以利用 goose 作为躯体,通过 MCP 作为神经系统感知外部世界,并遵循 AGENTS.md 这一大脑皮层中的规则进行决策。这种分层架构的标准化,将极大地降低 Agentic AI 的开发门槛。

行业巨头的集体背书

此次 AAIF 的支持阵容,除了三家创始成员外,亚马逊 AWS、谷歌、微软、Cloudflare 和彭博社等科技巨头均作为白金会员加入。这种跨越竞争关系的合作在科技史上并不多见。

Linux 基金会执行董事吉姆·赞林(Jim Zemlin)强调,AAIF 的目标是避免未来出现“封闭的围墙花园”,即工具连接、代理行为和编排都被锁定在少数几个专有平台上。对于 AWS 这样的云服务商来说,支持开放标准符合其长远利益。AWS 代理 AI 副总裁斯瓦米·西瓦苏布拉马尼亚(Swami Sivasubramanian)表示,将 MCP 等项目置于中立基金会,能让企业客户有信心在这些标准上构建关键业务流程,而不必担心底层协议的碎片化。

对于开发者来说,这意味着他们所掌握的技能将具有更强的通用性。学会编写 MCP 服务器,意味着你的工具可以同时服务于 Claude、ChatGPT、GitHub Copilot 以及未来可能出现的任何 AI 平台。这种技能的可迁移性,正如当年掌握 HTTP 协议或 SQL 语言一样,将成为 AI 时代开发者的核心竞争力。

从代码到生态:Agent 的未来

随着标准的统一, Agent 领域有望迎来类似移动互联网初期的应用爆发。AAIF 已经规划了后续的生态建设路径,包括定于 2026 年 4 月在纽约举行的首届官方 MCP 开发者峰会。围绕这些开放标准正在形成一个庞大的开发者社区。

OpenAI 的尼克·库珀在采访中提到,协议本质上是一种共享语言,它的价值在于沟通与协作。当数以万计的工具和服务都开始讲同一种“MCP 语言”,当所有的代码库都有了“AGENTS.md 说明书”,AI Agent 将不再是演示视频中那个笨拙的实验品,而能真正穿梭于复杂的数字系统中,成为开发者得力的助手。

参考链接: